Kiến Thức

Cache là gì?

Bộ nhớ đệm là gì?

Bộ nhớ đệm, còn được gọi là Cache, là một thành phần phần cứng hoặc phần mềm được lưu trữ tạm thời trong bộ nhớ ứng dụng hoặc thiết bị. Bộ nhớ đệm tự động lưu trữ dữ liệu mà người dùng sử dụng để giảm thời gian và công sức truy xuất dữ liệu vào lần truy cập ứng dụng hoặc thiết bị tiếp theo.

Bộ nhớ đệm(Cache) là một vùng lưu trữ tạm thời được sử dụng để lưu trữ dữ liệu được truy cập gần đây hoặc thường xuyên. Điều này giúp cải thiện hiệu suất bằng cách cho phép dữ liệu được truy cập trực tiếp từ bộ nhớ đệm, thay vì phải truy cập từ bộ nhớ chính. Bộ nhớ đệm thường được sử dụng bởi bộ xử lý trung tâm (CPU), ứng dụng, trình duyệt web và hệ điều hành.

Ví dụ, Khi bạn truy cập một trang web, trình duyệt sẽ tải nội dung của trang web đó vào bộ nhớ đệm. Khi bạn truy cập trang web đó lần sau, thay vì tải lại toàn bộ nội dung từ Internet, trình duyệt sẽ tải nhanh chóng từ bộ nhớ đệm.

Bộ nhớ đệm hoạt động như thế nào?

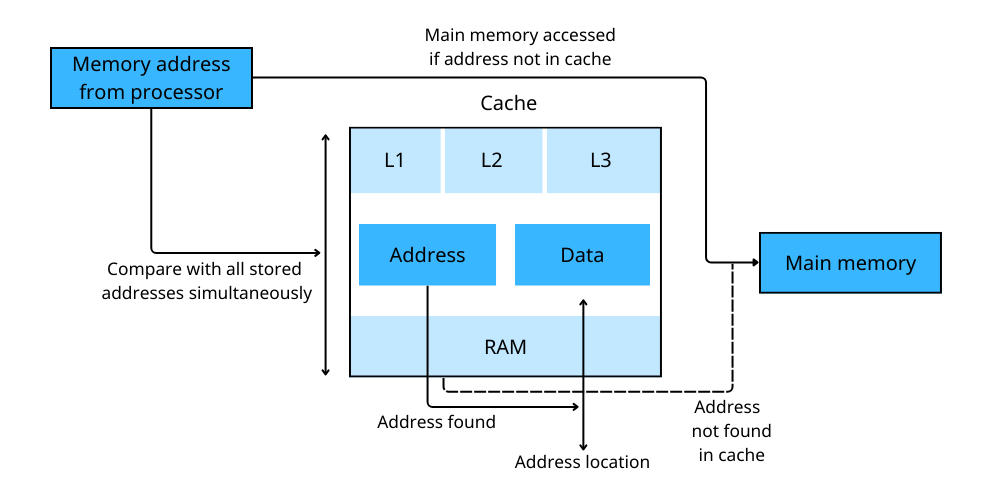

Khi một chương trình khởi động trên máy tính, dữ liệu sẽ được truyền từ RAM vào bộ nhớ đệm L3. Sau đó, dữ liệu sẽ được chuyển đến bộ nhớ đệm L2 và L1. Bộ nhớ đệm L1 là bộ nhớ đệm nhanh nhất và có dung lượng nhỏ nhất. Bộ nhớ đệm L3 là bộ nhớ đệm chậm nhất và có dung lượng lớn nhất.

Khi CPU cần truy cập dữ liệu, nó sẽ kiểm tra xem dữ liệu đó có được lưu trữ trong bộ nhớ đệm hay không. Nếu dữ liệu được lưu trữ trong bộ nhớ đệm, thì CPU có thể truy cập dữ liệu đó trực tiếp từ bộ nhớ đệm, thay vì phải truy cập từ bộ nhớ chính.

Lợi ích của Cache là gì?

Bộ nhớ đệm mang lại một số lợi ích đáng kể, bao gồm:

- Hiệu suất: Việc lưu trữ dữ liệu trong bộ nhớ đệm giúp máy tính hoạt động nhanh hơn. Ví dụ, bộ nhớ đệm của trình duyệt lưu trữ các tệp từ các phiên duyệt trước, giúp tăng tốc độ truy cập vào các phiên sau. Bộ nhớ đệm cơ sở dữ liệu cũng tăng tốc độ truy xuất dữ liệu, giúp tiết kiệm thời gian và tài nguyên so với việc phải tải xuống từ nguồn gốc.

- Hoạt động ngoại tuyến: Bộ nhớ đệm cho phép các ứng dụng hoạt động mà không cần kết nối internet. Bộ nhớ đệm ứng dụng cung cấp khả năng truy cập nhanh vào dữ liệu được truy cập gần đây hoặc thường xuyên. Tuy nhiên, bộ nhớ đệm có thể không cho phép truy cập vào tất cả các chức năng của ứng dụng.

- Hiệu quả về tài nguyên: Ngoài việc tăng tốc độ và tính linh hoạt, bộ nhớ đệm còn giúp tiết kiệm tài nguyên cho các thiết bị vật lý. Ví dụ, việc truy cập nhanh vào bộ nhớ đệm có thể giúp tiết kiệm pin cho thiết bị.

Hạn chế của bộ nhớ đệm là gì?

- Hỏng dữ liệu: Bộ nhớ đệm có thể bị hỏng, khiến dữ liệu được lưu trữ không còn hữu ích. Dữ liệu bị hỏng có thể khiến các ứng dụng như trình duyệt gặp sự cố hoặc hiển thị dữ liệu không chính xác.

- Hiệu suất: Bộ nhớ Cache là kho lưu trữ nhỏ bộ nhớ tạm thời. Nếu chúng quá lớn, chúng có thể làm giảm hiệu suất. Chúng cũng có thể tiêu tốn bộ nhớ mà các ứng dụng khác có thể cần, ảnh hưởng tiêu cực đến hiệu suất ứng dụng.

- Thông tin lỗi thời: Đôi khi bộ đệm ứng dụng hiển thị thông tin cũ hoặc lỗi thời. Điều này có thể gây ra trục trặc cho ứng dụng hoặc trả về thông tin sai lệch. Nếu một trang web hoặc ứng dụng được cập nhật trên internet, việc sử dụng phiên bản được lưu trong bộ nhớ đệm từ phiên trước đó sẽ không phản ánh bản cập nhật. Đây không phải là vấn đề đối với nội dung tĩnh nhưng là vấn đề đối với nội dung động thay đổi qua các phiên hoặc giữa các phiên.

Xóa bộ nhớ Cache có tác dụng gì?

Xóa bộ nhớ đệm có thể giúp giải phóng không gian bộ nhớ trên thiết bị. Bộ nhớ đệm của trình duyệt sử dụng bộ nhớ để lưu trữ các tệp được tải xuống từ web. Việc xóa nó có thể giúp giải quyết một số vấn đề của người dùng, bao gồm:

- Khi bộ nhớ đệm đầy, ứng dụng có thể gặp sự cố hoặc không tải đúng cách.

- Bộ nhớ đệm cũ có thể chứa thông tin và tệp lỗi thời, khiến trang web không tải hoặc tải không chính xác. Việc xóa Cache có thể loại bỏ những thông tin lỗi thời.

- Bộ nhớ đệm của trình duyệt cũng chứa thông tin cá nhân đã lưu, chẳng hạn như mật khẩu. Xóa chúng có thể giúp bảo vệ người dùng.

- Hầu hết bộ nhớ đệm của trình duyệt có thể được xóa thông qua cài đặt.

Tuy nhiên, việc xóa bộ nhớ Cache thường xuyên không phải là cách sử dụng tài nguyên hiệu quả vì:

- Người dùng sẽ mất lợi ích của việc truy cập nhanh vào các tệp.

- Bộ nhớ đệm tự động xóa một số tệp và không cần kiểu bảo dưỡng này.

- Máy tính sẽ lưu trữ các tập tin mới và lấp đầy lại dung lượng.

Sự khác biệt giữa Cache và Cookie là gì?

Bộ nhớ đệm và cookie đều là các công cụ được sử dụng bởi trình duyệt web, nhưng chúng có những mục đích khác nhau:

- Bộ nhớ đệm(Cache): Đây là nơi máy tính của bạn lưu trữ các tệp được tải xuống trực tiếp từ các trang web bạn truy cập – như phông chữ, hình ảnh và các thành phần tương tự. Các tệp trong bộ nhớ đệm của bạn không khác mấy so với các tệp trong bộ nhớ đệm của người khác truy cập cùng một trang web.

- Cookie: Ngược lại với bộ nhớ đệm(Cache), cookie lưu trữ thông tin về bạn và các hoạt động trực tuyến của bạn. Ví dụ, nếu bạn duyệt qua một cửa hàng trực tuyến và thêm nhiều mặt hàng vào giỏ hàng, thông tin này sẽ được lưu trong cookie. Cookie cũng theo dõi các trang web mà bạn đã đăng nhập – đó là lý do tại sao, nếu bạn xóa cookie, bạn sẽ phải đăng nhập lại vào tất cả các tài khoản của mình. Xóa bộ nhớ đệm của bạn không ảnh hưởng đến bất kỳ điều gì trong số này.

Xóa bộ nhớ đệm như thế nào?

Xóa bộ nhớ đệm trên điện thoại

Để xóa Cache trên điện thoại, bạn có thể thực hiện theo các bước sau:

- Bước 1: Mở cài đặt trên điện thoại của bạn

- Bước 2: Chọn ứng dụng mà bạn muốn xóa Cache

- Bước 3: Kéo xuống dưới chọn xóa lịch sử và dữ liệu trang web

- Bước 4: Xác nhận để tiến hành xóa Cache

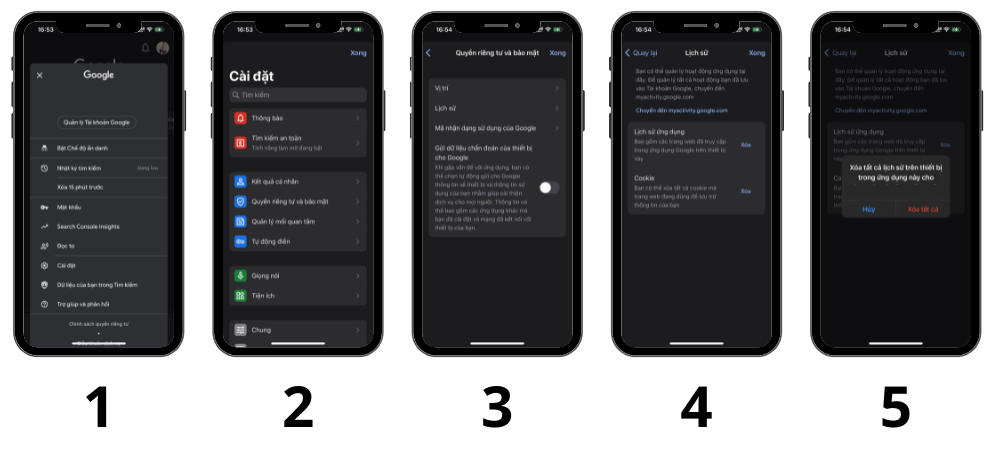

Nếu bạn muốn xóa cache của trình duyệt, bạn có thể thực hiện theo các bước sau:

- Bước 1: Mở trình duyệt và chạm vào biểu tượng tài khoản của bạn.

- Bước 2: Nhấn vào Quyền riêng tư và bảo mật.

- Bước 3: Chọn vào Lịch sử.

- Bước 4: Sau đó bạn chọn tác vụ muốn xóa từ danh sách. Ví dụ, xóa lịch ứng dụng

- Bước 5: Xác nhận để tiến hành xóa Cache

Lưu ý: Các bước cụ thể có thể khác nhau tùy thuộc vào loại điện thoại và phiên bản hệ điều hành của bạn.

Xóa bộ nhớ đệm trên PC – Laptop

Tùy thuộc vào trình duyệt web bạn đang sử dụng, các bước xóa bộ nhớ đệm có thể khác nhau. Nhưng bất kể trình duyệt là gì, việc này đều có thể thực hiện dễ dàng.

Cách xóa bộ nhớ đệm trong Google Chrome

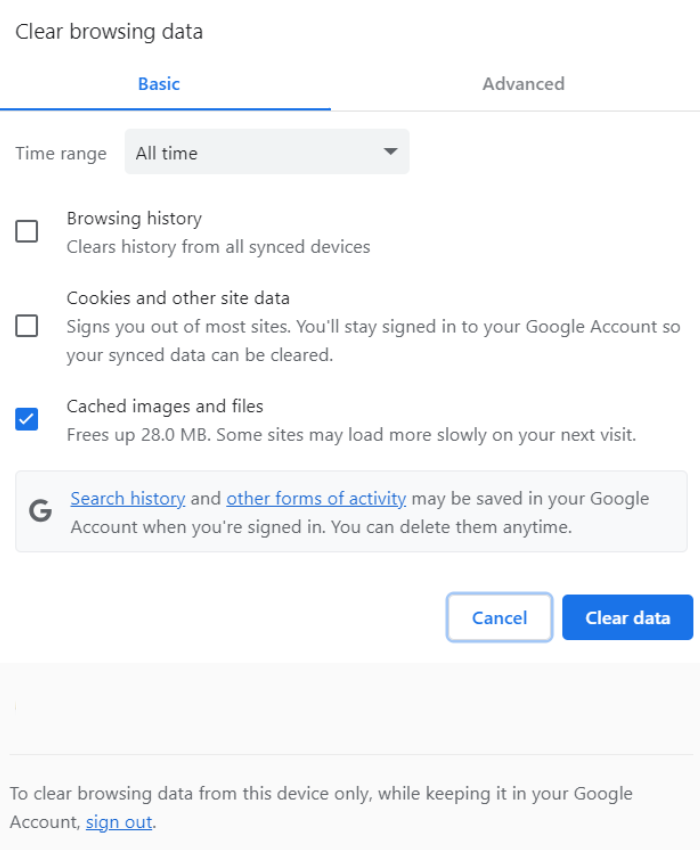

- Bước 1: Từ thanh menu của cửa sổ Google Chrome, nhấp vào

(⋮) - Bước 2: Nhấp vào

More Toolsvà chọnClear Browsing Data - Bước 3: Bạn sẽ được chuyển hướng đến cửa sổ bật lên trên trang Cài đặt của Google Chrome . Bỏ chọn

Cookies and other site data(trừ khi bạn muốn xóa cookie của mình), sau đó nhấp vàoClear data

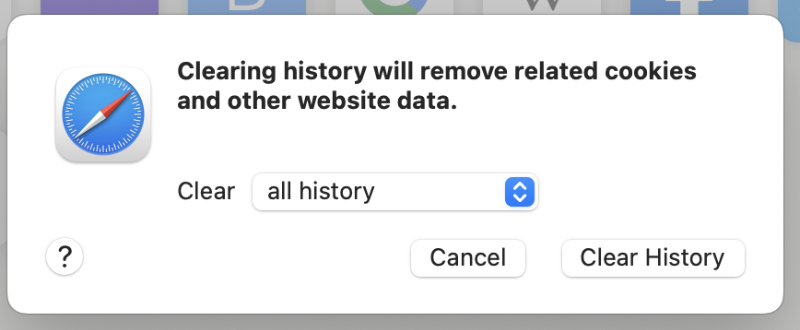

Cách xóa Cache trong Safari

- Bước 1: Trên thanh menu của máy Mac, nhấp vào

History, và chọnClear History - Bước 2: Trong cửa sổ bật lên, Tại

Clear, chọnall history(nếu muốn xóa hết lịch sử) - Bước 3: Cưối cùng chọn

Clear Historyđể xóa

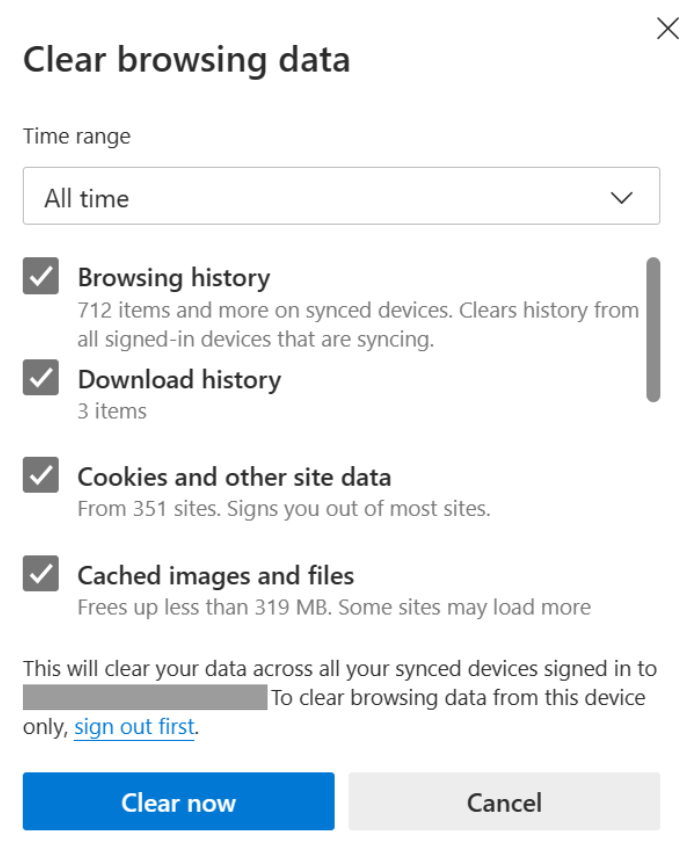

Cách xóa Cache trong Microsoft Edge

- Bước 1: Từ thanh menu của Microsoft Edge, chọn

(⋮) - Bước 2: Nhấp vào

Settingsrồi chọnPrivacy, search, and services - Bước 3: Trong phần

Clear browsing data, chọnChoose what to clear - Bước 4: Trong cửa sổ xuất hiện, chọn dữ liệu và thời gian mà bạn muốn xóa, sau đó nhấp vào

Clear now

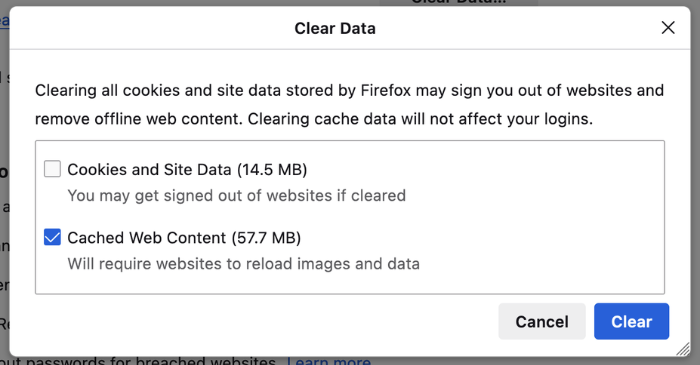

Cách xóa Cache trong Firefox

- Bước 1: Trên thanh menu của cửa sổ Firefox, nhấp vào

(≡), sau đó nhấp vàoSettings - Bước 2: Từ ngăn điều hướng, nhấp vào

Privacy & Security. - Bước 3: Trong phần Cookies and Site Data, nhấp vào

Clear Data - Bước 4: Trong cửa sổ bật lên xuất hiện, bỏ chọn

Cookies and Site Data(trừ khi bạn muốn xóa cookie của mình), sau đó nhấp vàoClear

Có nên xóa bộ nhớ đệm thường xuyên không?

Các tệp tin trong bộ nhớ đệm giúp tăng tốc độ tải các trang web bạn thường xuyên truy cập, điều này rất hữu ích. Trình duyệt của bạn sẽ tự động xóa các tệp cũ theo định kỳ, do đó, bộ nhớ đệm sẽ không liên tục tăng lên mãi mãi.

Bộ nhớ đệm(Cache) cũng chiếm một phần dung lượng trên ổ cứng của bạn. Điều này có thể gây phiền toái, đặc biệt nếu bạn có dung lượng lưu trữ hạn chế. Tuy nhiên, bạn cũng nên nhớ rằng, mục đích của ổ cứng là để lưu trữ mọi thứ trên đó. Vì vậy, chúng tôi khuyên bạn chỉ nên xóa bộ nhớ đệm khi cần thiết, chẳng hạn như khi bạn gặp sự cố với trình duyệt hoặc khi bạn cần giải phóng dung lượng.

Lời kết

Bộ nhớ Cache giúp cải thiện hiệu suất và giảm tải cho hệ thống và trang web. Tuy nhiên, người dùng cần phải quản lý cache một cách hiệu quả để tránh các vấn đề như bộ nhớ cache bị đầy hoặc nội dung lỗi thời do không cập nhật cache thường xuyên. Việc lập lịch để xóa và update cache thường xuyên có thể giải quyết các vấn đề ở trên.